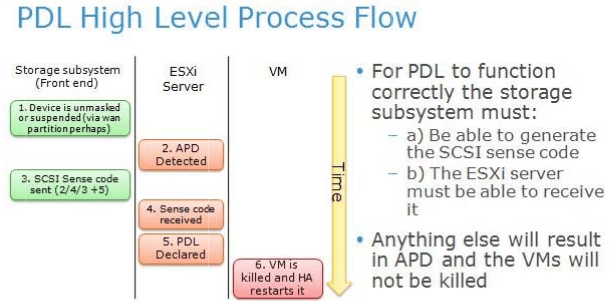

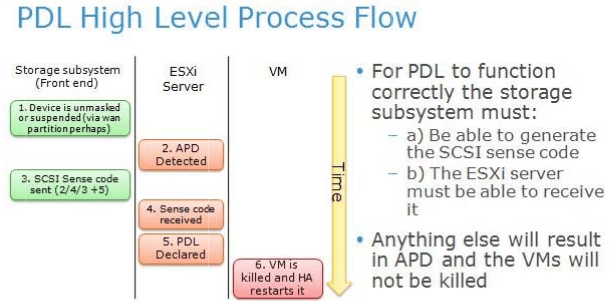

Начиная с версии 5.0 U1, vSphere различает два типа потери доступа к хранилищу: APD (All Paths Down) и PDL (Persistant Device Loss). Продолжить чтение «Как VMware vSphere реагирует на исчезновение устройства хранения — APD и PDL»

Путь саморазвития ИТ инженера

Начиная с версии 5.0 U1, vSphere различает два типа потери доступа к хранилищу: APD (All Paths Down) и PDL (Persistant Device Loss). Продолжить чтение «Как VMware vSphere реагирует на исчезновение устройства хранения — APD и PDL»

Вначале было слово и слово было Welcome.

Приветственные доклады слились в одну сумбурную презентацию миллионов IOPS и тысяч снапшотов в новой архитектуре Data Fabric, представляющую собой концепцию управления гибридными массивами и AFF (All-Flash-FAS) из одного управляющего интерфейса. Осталось непонятным, зачем столько снапшотов и клонов, и что всё-таки есть Data Fabric — программный инструмент управления или архитектура. Или концепция.

Зато лишний раз довелось убедиться, насколько живее, динамичнее и «заводнее» выступают европейские спикеры вендорских конференций.

После кофебрейка пошли технические доклады.

Продолжить чтение «Конспект с конференции NetApp Innovation 2015 (10 ноября)»

Настройки кэш-памяти контроллеров VNX можно найти на двух вкладках — SP Memory и SP Cache окна System Properties.

В SP Memory задаётся размер Read и Write кэша (для доступности изменения он должен быть отключен). С этим всё понятно. Стоит упомянуть лишь, что Write-кэш зеркалируется на обоих контроллерах, следовательно занимает вдвое больше памяти, чем Read. И именно под кэш записи стоит отдать большую часть памяти. Допустим, на VNX5100 из доступных 800+ МБ памяти под кэш чтения стоит выделить не больше 100, а на VNX550 из доступных 4,5ГБ — не больше 512 МБ. Каш на запись увеличивает общую производительность системы значительно сильнее.

В SP Cache можно отключить и включить Read и Write кэш, а также размер страницы (Page size) и Watermarks. Пару слов о последнем. Продолжить чтение «EMC VNX: параметры кэша (cache management)»

В рамках модернизации SAN произвожу массовый перенос устройств из одного FC-коммутатора в другой.

Некоторые ленточные библиотеки при этом ведут себя странно. Вместо положенных F-port и WWN в выводе switchshow отображается следующее:

19 19 720100 id N4 Online FC L-Port 1 public

Я бы не обратил внимания, если бы не ответственный за бэкап не пожаловался, что не видит библиотечный драйв. Продолжить чтение «FC switch, ленточная библиотека, L-port (public)»

Не очень понял, к чему было приурочено мероприятие. Разве что к тому, чтобы напомнить, что Brocade ещё жив. Технической информации было немного. Половина выступающих косноязычны (Brocade) или усыпляющи (IBM). Запомнившейся была презентация Smartoptics (Torsten Trapp), потому что на английском и потому что грамотно структурированная и донесённая) и HP (Владислав Логвиненко), потому что троллил конкурентов. Хотя последний вариант выступления рисковый, обычно вызывает наоборот неприязнь. Но тут было забавно. Да и выделился хоть как-то из довольно скучного ряда остальных спикеров.

Не очень понял, к чему было приурочено мероприятие. Разве что к тому, чтобы напомнить, что Brocade ещё жив. Технической информации было немного. Половина выступающих косноязычны (Brocade) или усыпляющи (IBM). Запомнившейся была презентация Smartoptics (Torsten Trapp), потому что на английском и потому что грамотно структурированная и донесённая) и HP (Владислав Логвиненко), потому что троллил конкурентов. Хотя последний вариант выступления рисковый, обычно вызывает наоборот неприязнь. Но тут было забавно. Да и выделился хоть как-то из довольно скучного ряда остальных спикеров.

Под катом заметки. Продолжить чтение «Интересное с семинара Brocade 09.09.2015»

Не буду расплываться банальными определениями репликации и её необходимости — если человек не знает этих вещей, дальнейшее ему вообще будет непонятно и не интересно. Скажу лишь, что речь идёт о необходимости репликации наборов данных в LUN на СХД. Статья написана по мотивам документа EMC VNX Replication Technologies и немного дополнена.

Итак, какие технологии предлагает EMC для организации катастрофоустойчивости. Продолжить чтение «Технологии репликации данных EMC»

У каждого вендора и даже у разных моделей дисковых массивов внутри одного вендора разные рекомендации по настройке Path Selection Policy (Fixed, Most Recent Used или Round Robin).

В ESX для основных вендоров реализованы специальные плагины (SATP — Storage Array Type Plugin), которые являясь частью Native Multipathing Plugin (NMP — механизма управления PSP) как раз и описывают использование определённой политики для определённых устройств.

К слову сказать, не всегда дефолтные значения SATP соответствуют рекомендациям вендора.

Посмотреть значения по умолчанию можно командой

~ # esxcli storage nmp satp list Name Default PSP Description ------------------- ------------- ------------------------------------------------------- VMW_SATP_CX VMW_PSP_MRU Supports EMC CX that do not use the ALUA protocol VMW_SATP_ALUA_CX VMW_PSP_RR Supports EMC CX that use the ALUA protocol VMW_SATP_ALUA VMW_PSP_MRU Supports non-specific arrays that use the ALUA protocol VMW_SATP_SVC VMW_PSP_FIXED Supports IBM SVC VMW_SATP_MSA VMW_PSP_MRU Placeholder (plugin not loaded) VMW_SATP_DEFAULT_AP VMW_PSP_MRU Placeholder (plugin not loaded) VMW_SATP_EQL VMW_PSP_FIXED Placeholder (plugin not loaded) VMW_SATP_INV VMW_PSP_FIXED Placeholder (plugin not loaded) VMW_SATP_EVA VMW_PSP_FIXED Placeholder (plugin not loaded) VMW_SATP_SYMM VMW_PSP_RR Placeholder (plugin not loaded) VMW_SATP_LSI VMW_PSP_MRU Placeholder (plugin not loaded) VMW_SATP_DEFAULT_AA VMW_PSP_FIXED Supports non-specific active/active arrays VMW_SATP_LOCAL VMW_PSP_FIXED Supports direct attached devices

В пятницу, заканчивая задачу по обновлению прошивок дисков в массивах EMC в рамках ETA195555 обнаружил, что в конце марта вышла прошивка 05.32.000.5.217 для массивов VNX.

Содержит внушительный список исправлений. Среди прочего, например, такие:

С частотой срабатывания «Always under a specific set of circumstances»

Более подробную информацию можно найти в docu58600_VNX-Operating-Environment-for-Block-05.32.000.5.217-Release-Notes.pdf.

Скачать и обновить можно через Unisphere Service Manager.

Да, я в курсе, что Clariion — уже устаревшая система, уже не продаётся, однако эксплуатируется. И, думаю, не только у нас.

Проблема в том, что от старости продукта, документация о нём не должна терять актуальность ведь? А если производитель в одном месте позволяет себе писать то, что не соответствует действительности, то могут быть и другие места.

При разметке дисков в Clariion в Storage Pool, при создании Raid6, вообще невозможно понять, сколько дисков будет использовано под Data, а сколько под Parity. Видно только, что рекомендуется использовать кратность 8, то есть кофнигурацию 6+2. Что делать, если дисков 10 или ещё как-то некратно восьми? Продолжить чтение «RAID6 в EMC Clariion — несоответствие документации факту»

Первая же боевая задача — презентовать несколько LUN под кластер Oracle на Solaris — получила неожиданный бонус-челлендж: настроить Solaris. Вообще-то это должны были делать швейцарские коллеги, от меня требовалось только предоставить диски и обеспечить совместимость железа, но наши незнакомые друзья из Швейцарии оказались ещё более криворукими чем я, так что задача «обновить прошивки на серверах» плавно переросла в «установить Solaris, настроить сеть, скопировать дистрибутивы с Win-сервера, презентовать LUN, настроить их в ОС и создать точки монтирования». То есть провести все подготовительные работы. С учётом того, что с unix-системами я не работал, а Solaris видел впервые в жизни, было увлекательно. Продолжить чтение «EMC VNX + Solaris: добавление LUN»

Для отправки комментария необходимо войти на сайт.